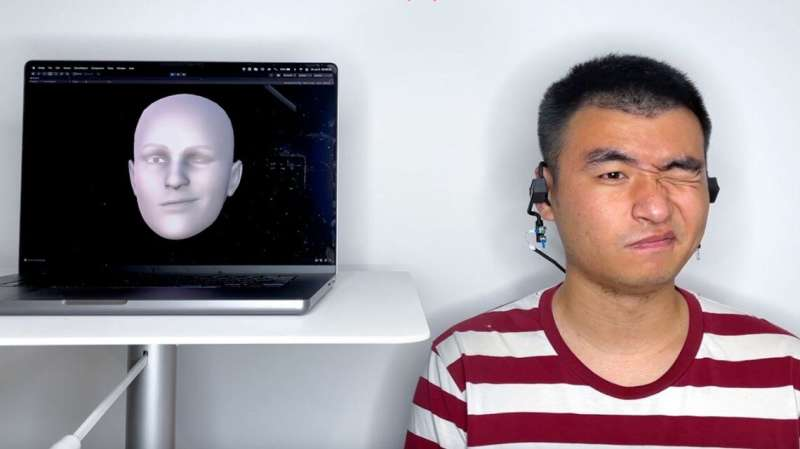

Исследователи из Корнелла разработали носимое устройство для наушников — или “earable”, — которое отражает звук от щек и преобразует эхо в изображение всего движущегося лица человека, используя акустические технологии для обеспечения лучшей конфиденциальности.

Команда, возглавляемая Чэн Чжаном, доцентом кафедры информатики, и Франсуа Гимбретьером, профессором информатики, разработала систему под названием EarIO. Она передает движения лица на смартфон в режиме реального времени и совместима с имеющимися в продаже гарнитурами для проведения беспроводных видеоконференций без помощи рук.

Устройства, которые отслеживают движения лица с помощью камеры, “большие, тяжелые и энергозатратные, что является большой проблемой для носимых устройств”, – сказал Чжан. “Также важно отметить, что они собирают много личной информации”.

По его словам, отслеживание лица с помощью акустической технологии может обеспечить лучшую конфиденциальность, доступность, комфорт и время автономной работы.

Команда описала свой наушник в статье “EarIO: A Low-power Acoustic Sensing Earable for Continuously Tracking Detailed Facial Movements”, опубликованной в Proceedings of the ACM по интерактивным, мобильным, носимым и повсеместным технологиям.

EarIO работает как корабль, посылающий импульсы гидролокатора. Динамик на каждой стороне наушников посылает акустические сигналы по бокам лица, а микрофон улавливает эхо-сигналы. Когда пользователи разговаривают, улыбаются или поднимают брови, кожа движется и растягивается, изменяя эхо-профили. Алгоритм глубокого обучения, разработанный исследователями, использует искусственный интеллект для непрерывной обработки данных и преобразования меняющихся эхо-сигналов в полные выражения лица.

“Благодаря мощи искусственного интеллекта алгоритм находит сложные связи между движением мышц и выражением лица, которые человеческие глаза не могут идентифицировать”, – сказал соавтор Ке Ли, доктор в области информатики. “Мы можем использовать это для вывода сложной информации, которую труднее уловить — всей передней части лица”.

Собирая звук вместо изображений с большим объемом данных, наушник может взаимодействовать со смартфоном через беспроводное соединение Bluetooth, сохраняя конфиденциальность информации пользователя.

“Люди могут не осознавать, насколько умны носимые устройства — что эта информация говорит о вас и что компании могут сделать с этой информацией”, – сказал Гимбретьер. С помощью изображений лица кто-то также может сделать вывод об эмоциях и действиях. “Цель этого проекта – быть уверенным, что вся информация, которая очень ценна для вашей конфиденциальности, всегда находится под вашим контролем и вычисляется локально”.

Использование акустических сигналов также требует меньше энергии, чем запись изображений. В настоящее время наушники работают около трех часов от батареи беспроводных наушников, но будущие исследования будут сосредоточены на увеличении времени использования.

Исследователи протестировали устройство на 16 участниках и использовали камеру смартфона, чтобы проверить точность его работы по имитации лица. Первоначальные эксперименты показывают, что он работает, когда пользователи сидят и ходят, и что ветер, дорожный шум и фоновые обсуждения не мешают его акустической сигнализации.

В будущих версиях исследователи надеются улучшить способность наушников дистанцироваться от близлежащих шумов и других помех.

Одним из ограничений технологии является то, что перед первым использованием EarIO должен собрать 32 минуты данных о лицах для обучения алгоритма.

Статья: Ke Li et al, EarIO: A Low-power Acoustic Sensing Earable for Continuously Tracking Detailed Facial Movements, Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies (2022). DOI: 10.1145/3534621